2024年に発売予定の「Apple Vision Pro」。XR対応だったり、形状がオシャレだったりと様々な特徴で話題の本製品ですが、特に注目なのが、本体前面に「利用者の顔」を表示する機能です。

これは「Apple Vision Pro」の前面ディスプレイに、利用者の顔を投影する仕組み。周囲の人の“違和感”を減らすことなどが目標みたいです。

普通のヘッドセットって、着用姿が結構アレですからね。Appleの考えも正直分かります。

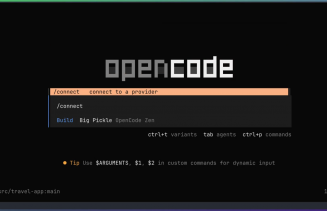

そんな表情表示システムですが先日、同システムをMeta Quest ProとiPhoneの組み合わせで制作した人が現れてしまいました。

作成者はAdam 放学臻さん。説明によると、まずQuest Proのフェイストラッキング(表情認識)機能のデータをスマホに送信。その後、iPhoneがユーザーの“3D目線”をレンダリングする形でシステムを実現したそうです。

映像では、見事Adamさんの表情がiPhoneの画面に映っているのが確認できます。綺麗に目や眉毛の動きを追ってますね。

眼球や脳みそ付き(ちょっとグロイ……)といった顔バリエーションのほか、“プライバシーモード”も搭載というこだわりっぷり。また、誰かが近づいた際に自動起動する機能も実装しているそうです。

参考:「Apple Vision Pro」の前面ディスプレイ

[ggads16]

「Apple Vision Pro」は、お値段3499ドル(約50万円)。約15万円のQuest ProとiPhone(14の場合、約10万円~約15万円)で、表情表示を成し遂げたのは、かなり素晴らしいんじゃないでしょうか。

なおAdamさんは、表情表示用のアプリ(iOS/Quest向け)を一般公開予定。プロジェクトのソースコードもシェアする計画とのことです。

現在の仕様だとiPhoneがQuest Proのセンサーを塞いでしまっていますが、頑張ればもっと洗練できるかもしれませんね。結構面白いアイディアので、頑張って開発を続けてほしいところです。