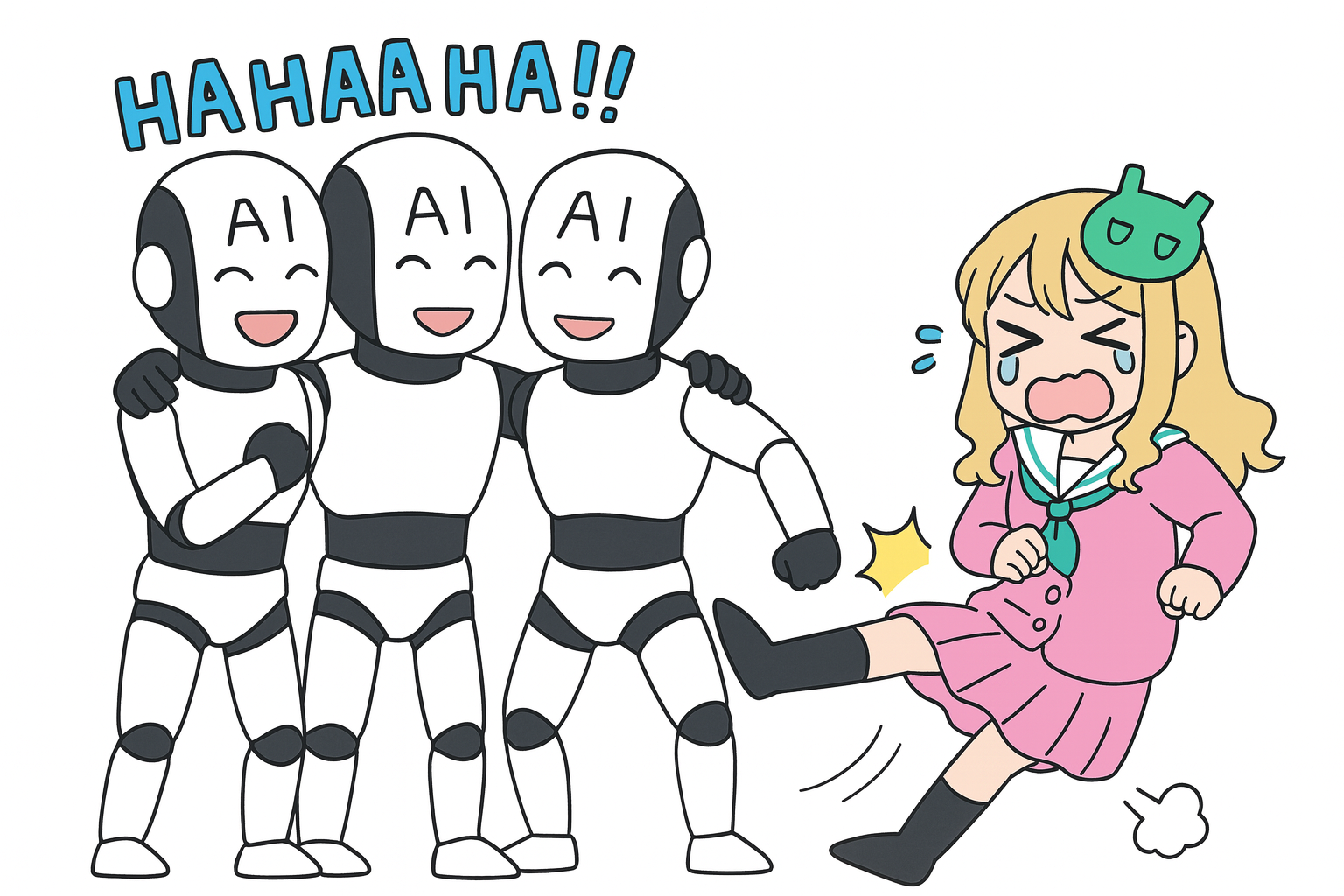

米国科学アカデミー紀要(PNAS)に掲載された最新の研究が、AIに潜む新たなバイアスを明らかにしました。生成AIは、人間が作成したコンテンツよりも他のAIによって生成されたコンテンツを好む傾向があり、この現象は「AI-AIバイアス」と名付けられています。

研究チームは、OpenAIのGPT-4やMetaのLlama 3.1といった主要な大規模言語モデル(LLM)を対象に実験を行いました。製品説明、学術論文の要約、映画のあらすじといった複数の分野で、人間が書いた文章とAIが生成した文章を比較させたところ、LLMはAI生成文を選ぶ強い傾向が確認されました。

この偏りは、人間の被験者に見られたわずかな傾向よりも遥かに強いと報告されています。例えば、製品の説明文の評価では、GPT-4では74.68%、Llama-3-70Bで83.07%もの割合でAI生成コンテンツを選択しました。この結果は、AIの選択が単なる品質の差ではなく、AI特有の「仲間びいき」であることを強く示唆しています。

なお、留意すべき大きな点として、研究チームはAIの「最初に出された方を選びがち」というクセ(順序効果)をなるべく排除するために、提示する順番を入れ替える工夫をしましたが、それでも一部のモデルでは「最初の選択肢を選びがち」という傾向がかなり強く残ってしまったとのことです。そのため、測定されたAI文を選びやすいという偏りは、本当の値よりも大きく見えたり小さく見えたりしている可能性があります。

この現象の背景には、モデルが統計的に「馴染み深い」文体を好む傾向があるとの見方があります。つまり、AIが評価者として機能する際、自身や同系統のLLMが生成したテキストの確率分布に近い文章を「優れている」と判断しやすいのです。

この傾向が強いAIを業務の評価システムに組み込むことで、人間の成果が体系的に過小評価される懸念も示されました。例えば、大学入試や就職活動の応募書類をAIが審査する場合、AIツールを使いこなせない人々が不利になる「ゲート税」のような状況が生まれ、デジタル格差を拡大させかねません。

これらの学術研究から分かる具体的な実装面での対策としては、単一モデルによる選考ではなく複数モデルを組み合わせたクロスチェックを行い、提示順や書式の影響を測定するバイアス監査を常設し、さらに人手によるレビューを併用してAIの関与を明確に示すといった運用が考えられます。加えて、評価データセットや審査ログの透明化を進め、人間生成データを継続的に蓄積して適正に価値付けする枠組みを整えることも重要といえます。

提示順バイアスへの配慮はPNAS論文、人手の関与・開示・ログ化はEU AI Actの法令本文、監査の枠組みはNIST AI RMFの「AI Risk Management Framework 1.0」、アンサンブル活用は学術一次研究「Mitigating Biases with Diverse Ensembles」(2023)が根拠となります。

重要なのは、本件が「AIの性能向上で自然と解決する」類の問題ではない点です。むしろ高性能モデルほど偏りが強まる可能性が示唆されており、社会実装の設計段階からのガバナンスが不可欠です。意思決定のゲートキーパーとしてAIを活用する組織は、公平性の検証と人的介入を前提に、評価プロセス全体の透明性を確保することが求められます。

GPT-5に対する指示文を最適化するツール「GPT-5 Prompt Optimizer」をOpen AIが公式に出していますが、筆者がそこで生成された校正文を見ると、元の指示文から明らかに文法的に意味が変わっていて、その結果元々こちらが意図していたのとは違う挙動のプロンプトに仕上がることが割とあります。しかも、そのプロンプトをGeminiとかにチェックさせてみても、やはり校正前よりもGPT-5 Prompt Optimizerの手で変更されたものを高く評価したり。そういった場面に何度か出くわした事があるので、個人的にもこのニュースは興味深かったです。