「感情は伝染する」と言われますが、これはネットの世界にも言えるようです。

米国科学アカデミー発行の機関誌、PNASに掲載された論文によると、Facebookのニュースフィード(タイムラインのようなもの)から悲観的な投稿を間引いた場合(=前向きな投稿を目にする機会が増える)、そのユーザーの書き込みは前向きなものになる傾向があり、反対に前向きな投稿を間引いた場合(=悲観的な投稿を目にする機会が増える)、書き込みも悲観的になる傾向が確認されたそうです。実社会と同様に、ソーシャルネットワーク上においても感情の伝染が起きることが明らかになったとこの論文では述べています。

とまあ、ここまでは「ふ〜ん」な話なのですが、問題はその調査方法。

Facebookは69万人ものユーザーのニュースフィードを無断で操作していた

被験者はランダムで抽出された一般のFacebookユーザー約69万人。英語で利用しているユーザーということなので日本語で利用されている方は対象外ですが、この膨大な被験者たちにはこの実験のことは全く何も知らされていません。普段通りにFacebookを使用する中で、いつの間にかフレンドの前向きな投稿が間引かれ、後ろ向きな書き込みばかり見せられ、自身も沈んだ気持ちにさせられたという事です。

数十万人もの感情を、研究目的とは言え、何の許可も無く操っていたことに多くのユーザーが憤慨しています。

The Atlanticが得たFacebookスポークスマンからのコメントを訳しました。

この調査は2012年のある1週間の間にのみ行われたもので、得られたデータは個々人のFacebookアカウントとは全く関連づけられていません。この様な研究はFacebook上に表示される情報の関連性と魅力を最大限に高めるために行われます。この研究は内容がポジティブかネガティブかに関わらず、フレンドからのお知らせやフォローしているページなど、異なるコンテンツタイプにユーザーがどう反応するかを理解するためのものです。私たちは熟考の上行う研究を決定し、社内には強力なレビュープロセスもあります。これらの研究のために不要なデータが収集されることはなく、全てのデータは安全に保管されています。

あまり納得できる内容ではないと感じます。

サービスが表示する内容には意図がある

人と繋がるためにSNSを利用するわけですが、友人の書き込みをサービス側の調査目的で何の通知も無く隠されては困ってしまいます。元々、Facebookニュースフィードのデフォルト設定である「ハイライト」にはフィルタがかかっており、Facebook側の秘密のアルゴリズムによってユーザーが興味を持たないであろうと判断された情報は表示されません。このアルゴリズムの精度の高さを信頼して、私たちは「ハイライト」表示を使っている訳ですが、今回のような件が明るみに出ると安心して利用することが難しくなってしまいます。多くのユーザーを抱え影響力も甚大なFacebook。透明性の高い運営を期待したいものです。

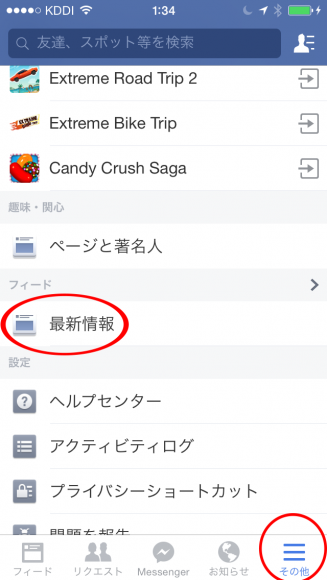

P.S. 極力Facebookによる勝手フィルタを避けたい場合は、ニュースフィードの設定を「最新情報」にしましょう。ブラウザ版であれば、左上に表示されている「ニュースフィード」横の下向き矢印から設定できます。

スマホアプリ版Facebookでは、三本線のアイコンから飛ぶ必要があります。

iPhone版は右下にある「その他」ボタンから「最新情報」を選択。

Android版では右上にある「さらに見る」ボタンから、同様に「最新情報」を選択してください。

The Next Webにもあるように、私たちがインターネットから得られる情報のほとんどは何らかのアルゴリズムによって抽出され、ソートされたものです。Google検索した結果はGoogleが開発したアルゴリズムによって抽出/ソートされた結果ですし、他のサービスでも同様です。ユーザーとしては表示される内容・順位を鵜呑みにするのでなく、過度なフィルタリングが行われていないか、有意義な情報が上位に表示されているか、注意して見ていく必要があるのかも知れません。