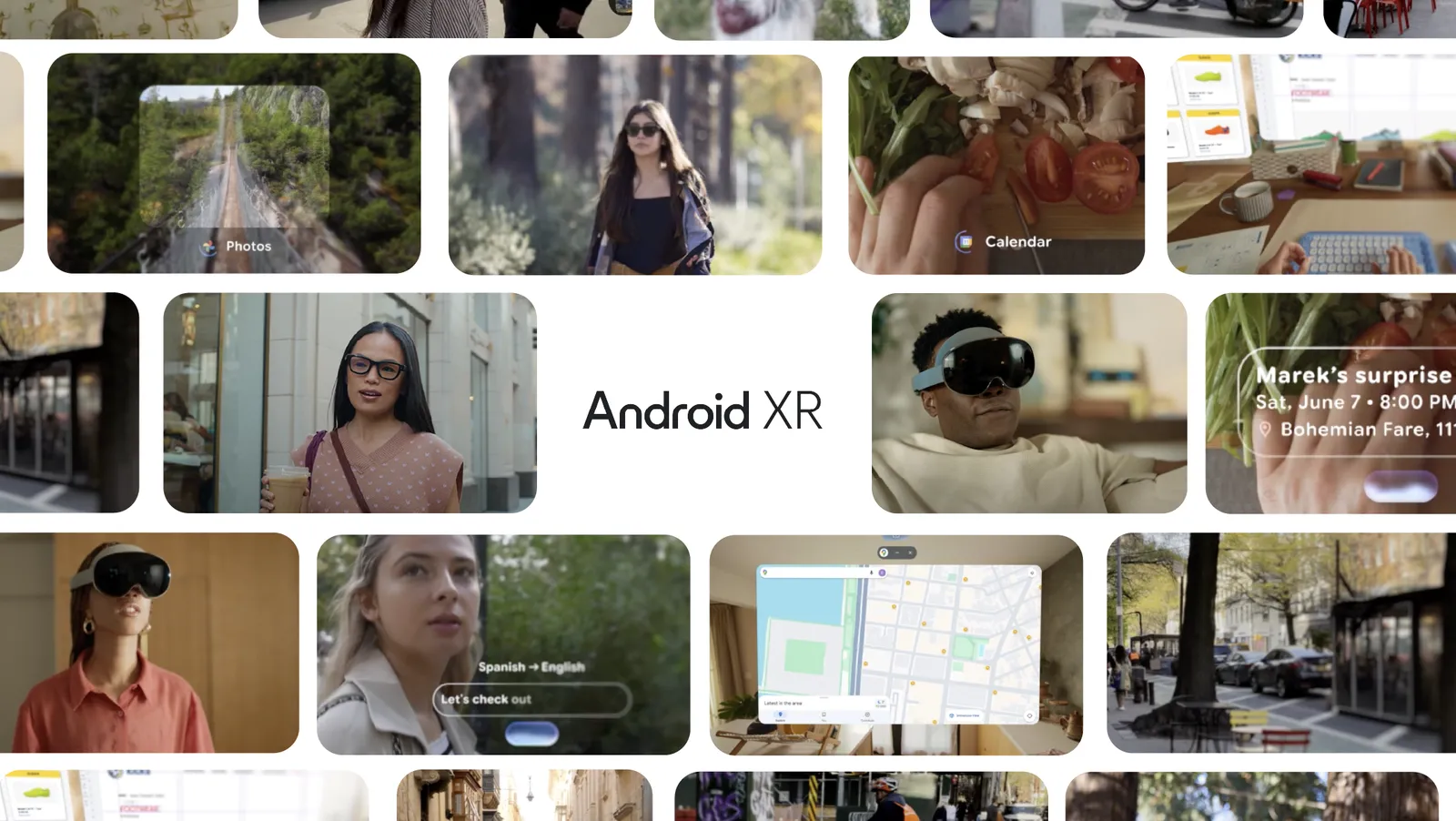

Googleは年次開発者会議「Google I/O」において、同社のAI「Gemini」を搭載した次世代スマートグラスの構想を発表しました。Android XRプラットフォームを基盤とし、スマートフォンを取り出すことなく、AIアシスタントがハンズフリーで利用できる未来を目指します。

カメラ、マイク、スピーカーを載せたAndroid XR搭載スマートグラス。Geminiと連携することで、ユーザーが見ているものや聞いていることをAIが理解し、文脈に合わせたサポートを提供。例えば、リアルタイムでの言語翻訳、友人へのメッセージ送信、予約作成、道案内、写真撮影など。これにより、ユーザーは現実世界や仮想世界に集中したまま、必要な情報を得たり操作したりできるようになるそうです。

Googleは、スマートグラス普及の鍵となる「日常的に使いたくなるデザイン」の実現に向け、新たな提携も発表。Samsungとの協力関係をヘッドセットだけでなくグラスへと拡大し、ソフトウェアとリファレンスハードウェアのプラットフォームを共同開発します。

さらに、スタイリッシュなアイウェアブランドとして知られるGentle Monster(ジェントルモンスター)やWarby Parker(ワービーパーカー)との提携も発表。将来的にはKering Eyewear(ケリングアイウェア)など、さらに多くのパートナーとの協力を予定しており、ファッション性と実用性を両立した製品を目指します。

ちなみに、Meta社のRay-Banスマートグラスなんかを見ても分かる通り、ライバルのMetaはスマートグラス普及の鍵としておしゃれなデザインの眼鏡をかなり意識してるみたいなんですよね。今回の発表を見る限り、Googleもそこは同意してるって感じですね。

また、最初のAndroid XR対応グラスは、Xreal社が「Project Aura」として製造することも明らかにされました。

Googleは、これらのグラス向けの開発者プラットフォームを年後半に提供開始予定です。また、プライバシーを尊重した製品開発のため、すでに「信頼できるテスター」からのフィードバック収集を開始しているとのこと。デバイスの提供時期など、詳細については今後数ヶ月以内に発表される見込みです。